Bienvenue dans mon guide détaillé sur le référencement technique - un sujet souvent négligé dans le marketing numérique, mais qui est crucial pour le succès de votre site. Le SEO technique peut sembler aride au premier abord, mais croyez-moi, l'impact sur votre visibilité dans les moteurs de recherche est immense. Dans cet article, nous allons plonger en profondeur dans les complexes de thèmes Crawlability, Indexation, Schema.org et Core Web Vitals et nous verrons comment optimiser ces aspects de votre site. Je vous montrerai comment utiliser à la fois Yoast SEO et RankMath pour faire passer le référencement technique de votre site WordPress au niveau supérieur. Si vous avez besoin d'informations de base sur l'optimisation pour les moteurs de recherche, je vous conseille de lire mon article sur le sujet. guide SEO complet de YoastLa base est posée.

SEO technique 2024 : guide complet sur l'optimisation des sites web

Optimisez votre site pour 2024 : Crawlability, indexation, Schema.org et Core Web Vitals.

Prestataire du cours: Personne

Nom du prestataire du cours: Saskia Teichmann

URL du prestataire du cours: https://www.saskialund.de/

Mode de cours: En ligne

Charge de travail des cours: PT01H

Type de cours: Gratuit

Crawlability : la base d'une indexation réussie

La crawlabilité est l'un des aspects les plus importants, mais souvent négligés, du référencement technique. Sans un site web bien structuré et exploitable, les moteurs de recherche ne peuvent pas saisir correctement votre contenu, ce qui signifie que vos pages peuvent ne pas apparaître du tout dans les résultats de recherche. La "crawlability" fait référence à la capacité des robots des moteurs de recherche à parcourir votre site web et à comprendre quelles pages doivent être indexées. Plongeons-nous dans ce sujet pour nous assurer que votre site est parfaitement préparé pour les moteurs de recherche.

Comprendre comment les moteurs de recherche explorent

Les moteurs de recherche, notamment Google, utilisent des "crawlers" ou "bots" pour explorer Internet. Ces robots suivent les liens de votre site web afin de découvrir et d'indexer de nouveaux contenus. Le crawler commence généralement par votre page d'accueil et suit ensuite les liens internes vers d'autres pages. C'est pourquoi un linking interne propre et bien structuré est décisif pour une crawlability réussie.

Des points importants :

- Lien interne robuste : Veillez à ce que chaque page importante de votre site soit accessible par au moins un lien interne. Pour ce faire, utilisez une hiérarchie de pages plate, de sorte qu'aucune page importante ne soit à plus de trois clics de la page d'accueil. En savoir plus sur les liens internes dans mon guide SEO Yoast complet.

- Structure URL propre : Vos URL doivent être courtes, descriptives et dépourvues de paramètres inutiles. Évitez les URL dynamiques, souvent créées par des ID de session ou des paramètres de filtrage, car elles sont plus difficiles à comprendre pour les robots d'exploration.

Optimiser le fichier Robots.txt

Le fichier Robots.txt est un petit document texte stocké sur votre serveur qui indique aux moteurs de recherche les parties de votre site web qui peuvent être explorées et celles qui ne peuvent pas l'être. Un document Robots.txt correctement configuré peut empêcher l'exploration de pages non importantes telles que les zones d'administration, les résultats de recherche internes ou d'autres pages non pertinentes.

Les étapes de l'optimisation :

- Limiter l'accès : Bloquez les contenus de page non importants ou en double. Cela pourrait par exemple concerner les pages avec des identifiants de session, les pages de recherche interne ou les pages de catégories en double.

- Autoriser l'accès : Veillez à ce qu'aucun site important ne soit bloqué par inadvertance. Cela peut facilement arriver si une règle générale est trop stricte.

- Utiliser le testeur Robots.txt : Utilisez l'outil de test Robots.txt dans la Google Search Console pour vous assurer que votre fichier fonctionne correctement et ne bloque pas de zones importantes.

Conseil de lecture :

Google Search Central : Introduction Robots.txt - Une ressource officielle de Google qui explique comment configurer et optimiser correctement votre fichier Robots.txt.

Les sitemaps XML et leur rôle dans la crawlability

Un sitemap XML est un fichier qui offre aux moteurs de recherche un aperçu de toutes les pages indexables de votre site web. Ces sitemaps aident Google et les autres moteurs de recherche à découvrir et à explorer vos pages plus rapidement, en particulier si votre site comporte de nombreuses pages ou est nouveau.

Les meilleures pratiques :

- Création automatique d'un plan du site : Utilisez des plugins SEO comme Yoast SEO ou RankMath pour générer et mettre à jour automatiquement votre sitemap XML. Ces plugins garantissent que toutes les nouvelles pages sont automatiquement intégrées dans le sitemap. Vous trouverez d'autres conseils dans mon Guide SEO de Yoast.

- Soumettre le plan du site : Soumettez votre sitemap à la Google Search Console afin de vous assurer qu'il sera exploré. C'est particulièrement important si vous apportez des modifications importantes à votre site.

- Structure du plan du site : Veillez à ce que votre sitemap ne soit pas surchargé. Un sitemap typique ne devrait pas contenir plus de 50.000 URL. Si c'est le cas, vous devriez les diviser en plusieurs sitemaps.

Conseil de lecture :

Moz : L'importance des plans de site XML - Un guide sur l'importance des sitemaps XML et leur optimisation.

Éviter les pièges du crawling

Les pièges de l'exploration sont des pages ou des liens de votre site Web qui retiennent inutilement les robots d'exploration "prisonniers" pendant longtemps, sans que des contenus pertinents soient découverts. Ces pièges peuvent avoir pour conséquence que des pages importantes ne soient pas explorées, car le robot d'exploration perd son temps à des endroits moins pertinents.

Exemples et solutions :

- Pages de recherche interne : Évitez que vos pages de résultats de recherche internes soient indexées par les robots d'exploration en les bloquant dans le fichier Robots.txt.

- Pagination : Si votre site utilise la pagination (par exemple dans un blog), assurez-vous qu'elle est correctement configurée et qu'elle ne provoque pas de boucles infinies. Lisez plus à ce sujet dans mon guide Yoast SEO.

- Infinite Scroll : Si votre site utilise une fonction de défilement infini, assurez-vous que tous les contenus sont également accessibles via des liens normaux.

Conseil de lecture :

Search Engine Journal : Éviter les pièges à crawl - Comment reconnaître et éviter les pièges du crawling.

Utiliser efficacement le budget Crawl

Le budget d'exploration désigne le nombre de pages qu'un robot d'exploration parcourt lors d'une visite sur votre site Web. Les sites Web comportant de nombreuses pages ou très complexes doivent être particulièrement attentifs à ne pas gaspiller leur budget d'exploration.

Stratégies d'optimisation :

- Utilisation de Noindex : Mettez le

noindex-attribut pour les pages qui ne doivent pas apparaître dans les résultats de recherche afin d'économiser le budget d'exploration. - Éviter le contenu dupliqué : Assurez-vous qu'il n'y a pas de contenu dupliqué sur votre site web, ce qui pourrait épuiser inutilement le budget d'exploration.

- Priorisation des pages importantes : Effectuez une priorisation des pages les plus importantes afin qu'elles soient explorées et mises à jour plus fréquemment.

Conseil de lecture :

Le blog d'Ahref : Crawl Budget Optimization - Un aperçu profond de l'importance et de l'optimisation du budget crawl.

Analyser les statistiques de crawl

Une étape importante pour optimiser la crawlabilité consiste à analyser régulièrement vos statistiques d'exploration dans la Google Search Console. Celles-ci vous indiquent la fréquence d'exploration de votre site, les pages qui reçoivent le plus de visites et si vous rencontrez des problèmes lors de l'exploration.

Conseils pour l'analyse :

- Contrôle régulier : Consultez les statistiques d'exploration au moins une fois par mois afin d'identifier les changements dans l'activité d'exploration.

- Identifier les problèmes : Soyez attentif aux chutes soudaines des taux d'exploration ou aux erreurs répétées qui pourraient indiquer que certaines pages sont difficiles d'accès pour le robot d'exploration.

- prendre des mesures d'optimisation : Si des problèmes sont identifiés, adaptez votre fichier Robots.txt, votre plan de site ou vos liens internes en conséquence.

Conseil de lecture :

Aide de la Google Search Console : Crawl Stats - Instructions pour l'analyse des statistiques d'exploration dans la Google Search Console.

Conclusion sur la crawlabilité de votre site web

Une bonne crawlabilité est la clé d'une indexation réussie de votre site web et donc de sa visibilité dans les résultats de recherche. Si vous mettez en œuvre les mesures décrites ici, vous veillez à ce que les moteurs de recherche puissent saisir vos contenus de manière efficace et complète. Utilisez les outils et les fonctions que vous offrent Yoast SEO, RankMath, d'autres outils On Page SEO comparables et la Search Console de Google pour surveiller et améliorer en permanence la crawlability de votre site.

Indexation : comment mettre vos contenus sous les feux de la rampe

L'indexation est une étape cruciale de l'optimisation pour les moteurs de recherche. Alors que la crawlabilité garantit que les moteurs de recherche peuvent trouver vos pages, l'indexation veille à ce que ces pages apparaissent dans les résultats de recherche. Si une page n'est pas indexée, elle est tout simplement ignorée par les moteurs de recherche, quelle que soit la qualité de son contenu. Plongeons au cœur de l'indexation et assurons-nous que vos contenus reçoivent l'attention qu'ils méritent.

Comprendre les bases de l'indexation

L'indexation est le processus par lequel les moteurs de recherche ajoutent à leur index les pages trouvées sur un site web. Cet index est une énorme base de données qui contient toutes les pages que Google & Co. peuvent afficher dans les résultats de recherche. Chaque page indexée est évaluée sur la base des informations stockées dans l'index des moteurs de recherche et affichée lors de requêtes de recherche pertinentes.

Aspects importants :

- Googlebot et autres robots d'exploration des moteurs de recherche : Lorsque le robot Googlebot parcourt votre site, il décide des pages à inclure dans l'index. Des facteurs tels que la pertinence du contenu, la structure technique de la page et l'expérience utilisateur jouent un rôle.

- Pages non indexées : Les pages qui ne sont pas indexées ne peuvent pas être trouvées par les utilisateurs via les moteurs de recherche. Ces pages n'ont aucune influence sur le classement de votre site dans les moteurs de recherche.

Paramètres d'indexation dans Yoast SEO et RankMath

Yoast SEO et RankMath offrent tous deux des moyens conviviaux de contrôler l'indexation de vos pages. Ces outils vous permettent de définir précisément quelles pages, articles, catégories et balises doivent apparaître ou non dans les résultats de recherche.

Yoast SEO :

- Étape 1 : Dans votre tableau de bord WordPress, allez dans "SEO" > "Apparence dans la recherche".

- Étape 2 : Sélectionnez l'onglet "Types de contenu" pour contrôler l'indexation des pages et des articles.

- Étape 3 : Déterminez si des pages individuelles ou des types de publications doivent être affichés dans les résultats de recherche et personnalisez les paramètres si nécessaire.

RankMath :

- Étape 1 : Naviguez vers "RankMath" > "Titre & Meta".

- Étape 2 : Sélectionnez l'onglet correspondant aux contributions, aux pages ou aux médias.

- Étape 3 : Utilisez les paramètres "Indexer" pour déterminer quel contenu doit apparaître dans les résultats de recherche.

Conseil Si vous souhaitez supprimer une page ou un article de l'index, définissez la balise "noindex" dans les paramètres du plugin concerné.

La signification de la balise Noindex

Le site noindex-est un outil puissant en matière de référencement, que vous pouvez utiliser pour exclure certaines pages de l'indexation. Cela peut être utile pour éviter le contenu dupliqué ou pour empêcher les pages non pertinentes d'apparaître dans les résultats de recherche.

Exemples d'applications :

- Pages de résultats de recherche internes : Ces pages n'apportent aucune valeur ajoutée aux internautes qui effectuent des recherches via Google et doivent donc être signalées par des

noindexde l'entreprise. - Pages en double ou similaires : Si vous avez des contenus similaires sur différentes pages, utilisez

noindexLes sites de la communauté sont souvent des sites de référence pour les contenus de la communauté, afin d'éviter que Google n'indexe des contenus dupliqués. - Pages sensibles : Les pages telles que "Protection des données", "Conditions générales" ou "Connexion" ne doivent généralement pas être indexées.

Les meilleures pratiques :

- Contrôle par la Google Search Console : Vérifiez régulièrement dans la Google Search Console quelles pages sont indexées et si

noindexest utilisé correctement. - Application stratégique : Mettre en place

noindexde manière ciblée afin d'utiliser efficacement le budget d'exploration et de concentrer l'indexation sur les pages les plus importantes.

Éviter le contenu dupliqué

Le contenu dupliqué est l'un des plus grands ennemis d'une indexation propre. Les moteurs de recherche sont conçus pour privilégier les contenus uniques et précieux. Si votre site contient plusieurs pages au contenu identique ou très similaire, cela peut entraîner des problèmes tels que le déclassement dans les résultats de recherche ou la suppression totale de ces pages de l'index.

Stratégies de prévention :

- URL canoniques : Utilisez la balise Canonical (

rel="canonical") pour indiquer quelle version d'une page est la version principale. Cela est particulièrement utile lorsque des contenus similaires sont accessibles via différentes URL. - Catégorisation et marquage : Évitez de répéter le même contenu sur plusieurs pages de catégories ou de tags. Utilisez plutôt des balises canoniques ou le

noindex-pour ces pages. - Gestion de contenu : Vérifiez régulièrement votre contenu pour vous assurer qu'il n'y a pas de pages en double ou redondantes.

Conseil de lecture :

Moz : Le guide définitif du contenu dupliqué - Un guide complet pour vous aider à éviter le duplicate content et à garder votre site propre.

Optimisation des pages prioritaires

Toutes les pages n'ont pas la même valeur. Certaines pages, comme votre page d'accueil, les pages de produits importantes ou les articles de blog qui génèrent régulièrement beaucoup de trafic, doivent être prioritaires dans votre stratégie de référencement.

Les meilleures pratiques :

- Demandes d'indexation manuelles : Utilisez la fonction "Vérification de l'URL" dans la Google Search Console pour vous assurer que vos pages les plus importantes sont correctement indexées. Soumettez-les manuellement à l'indexation si elles ne sont pas encore indexées.

- Optimisation du contenu : Veillez à ce que les pages hautement prioritaires soient régulièrement mises à jour et optimisées afin de conserver leur pertinence.

- Lien interne : Faites régulièrement des liens vers ces pages prioritaires à partir de nouveaux articles ou de pages importantes afin de renforcer leur visibilité et leur classement dans les résultats de recherche.

Conseil de lecture :

Search Engine Journal : Prioriser le contenu pour la réussite du SEO - Un guide pour prioriser vos contenus afin d'obtenir un maximum de résultats en matière de référencement.

La Google Search Console : Votre tableau de bord pour l'indexation

La Google Search Console est l'un des outils les plus puissants dont vous disposez pour surveiller et optimiser l'indexation de votre site. Grâce aux fonctions de vérification de l'index et aux rapports de couverture, vous obtenez des informations détaillées sur l'état de l'indexation de vos pages.

Fonctions importantes :

- Vérification de l'URL : Vérifier si une URL spécifique est indexée et s'il y a des problèmes d'indexation.

- Rapport de couverture : Voir quelles pages ont été indexées, quelles erreurs sont survenues et quelles pages ont été exclues de l'indexation.

- Demandes d'indexation manuelles : Utilisez cette fonction pour faire indexer rapidement les pages modifiées ou nouvelles.

Conseil de lecture :

Aide de la Google Search Console : Rapport de couverture d'index - Un guide détaillé sur l'utilisation du rapport de couverture dans la Google Search Console.

Conclusion sur l'indexation

L'indexation est la clé qui permet à votre contenu d'apparaître dans les résultats de recherche et d'être trouvé par les utilisateurs. En contrôlant stratégiquement l'indexation à l'aide d'outils tels que Yoast SEO et RankMath, en évitant le contenu dupliqué et en donnant la priorité à vos pages les plus importantes, vous pouvez vous assurer que votre site Web obtient des performances optimales. Utilisez la Google Search Console pour surveiller régulièrement l'état de l'indexation de vos pages et procéder à des ajustements si nécessaire. Vous trouverez d'autres informations détaillées dans mon Guide SEO de Yoast.

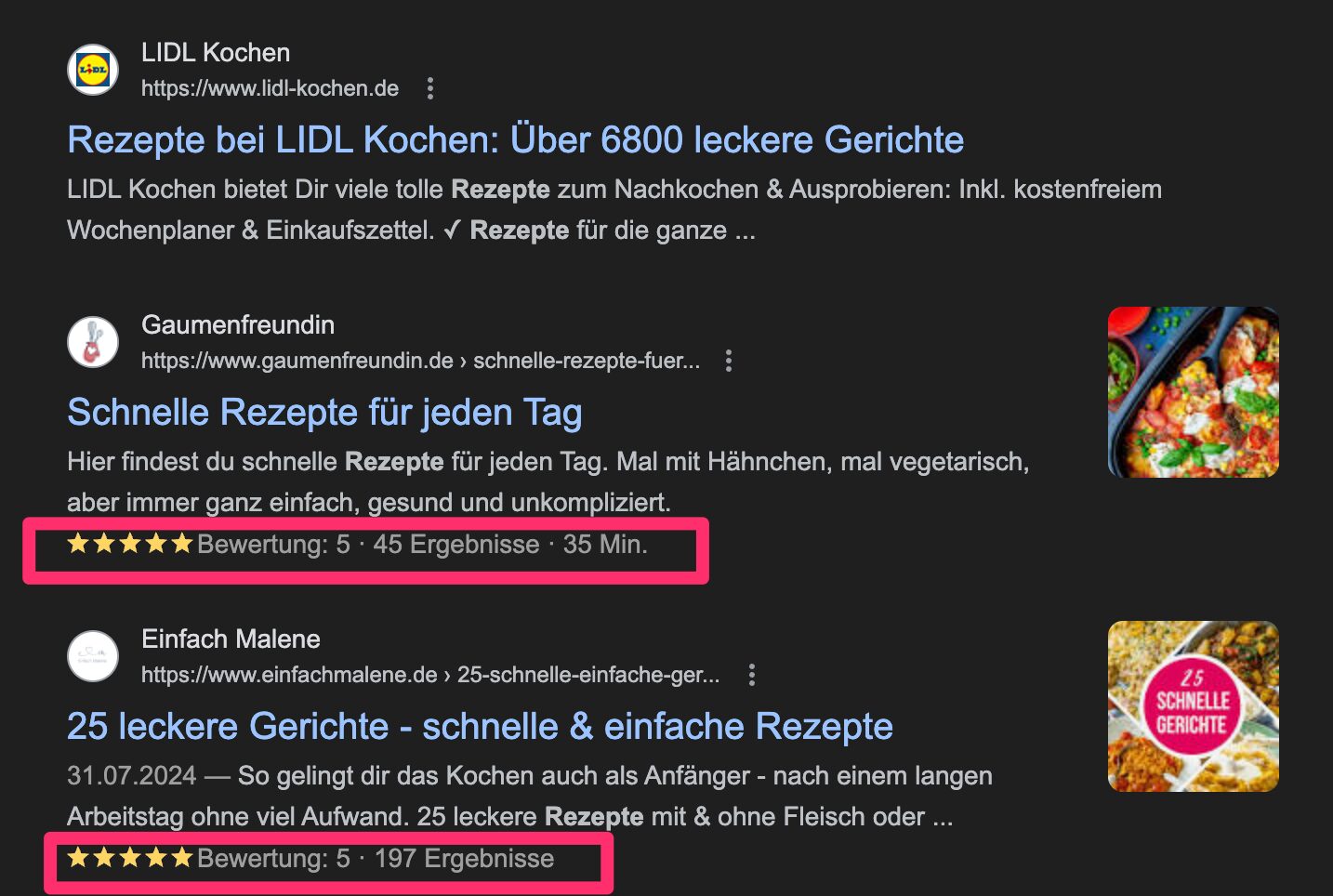

Schema.org : Des données structurées pour de meilleurs résultats

Les données structurées sont un élément central de l'optimisation moderne des moteurs de recherche. Elles permettent aux moteurs de recherche de mieux comprendre le contenu de votre site web et de le présenter de manière attrayante dans les résultats de recherche. En implémentant le balisage Schema.org, vous pouvez créer des extraits enrichis qui augmentent votre taux de clics (CTR) et votre visibilité.

Que sont les données structurées et pourquoi sont-elles importantes ?

Les données structurées sont des formats standardisés qui fournissent des informations sur une page et les éléments qu'elle contient. Les moteurs de recherche utilisent ces données pour mieux saisir le contexte des contenus et les valoriser visuellement dans les résultats de recherche. Des exemples sont les évaluations, les prix, les FAQ ou les données d'événements, qui peuvent être affichés directement dans les résultats de recherche.

Avantages :

- Amélioration de la visibilité : Les pages contenant des données structurées ont plus de chances d'être affichées en tant que Rich Snippets, ce qui augmente l'attention des utilisateurs.

- Taux de clics plus élevé : Les extraits enrichis offrent une valeur ajoutée supplémentaire dans les résultats de recherche et incitent davantage les utilisateurs à cliquer sur votre résultat.

- Des résultats de recherche plus pertinents : Les données structurées aident les moteurs de recherche à mieux interpréter le contenu de votre site et à le rendre plus pertinent pour des requêtes de recherche appropriées.

Comment insérer des données structurées avec Yoast SEO et RankMath

Les deux plug-ins WordPress, Yoast SEO et RankMath, offrent des moyens conviviaux d'intégrer des données structurées dans votre site web. Ces outils permettent d'implémenter facilement le balisage de schémas sans avoir besoin de connaissances techniques approfondies.

Yoast SEO :

- Étape 1 : Dans le tableau de bord WordPress, accédez à "SEO" > "Apparence dans la recherche".

- Étape 2 : Sous "Général", vous pouvez définir des informations de base comme le type de site web (organisation ou personne) et le logo de votre entreprise.

- Étape 3 : Dans l'onglet "Types de contenus", vous pouvez activer et adapter le balisage de schémas pour des types de contenus spécifiques (par ex. articles, pages).

RankMath :

- Étape 1 : Allez à "RankMath" > "Schéma".

- Étape 2 : Choisissez parmi une liste de types de schémas prédéfinis, comme "article", "produit" ou "FAQ", le type qui convient à votre contenu.

- Étape 3 : Personnalisez le schéma en remplissant des champs spécifiques tels que l'auteur, la date de publication et d'autres informations pertinentes.

Conseil Utilisez les outils de validation Schema Markup de Google pour vous assurer que vos données structurées sont correctement mises en œuvre.

Principaux types de schémas et leur application

Il existe de nombreuses Types de schémasVous pouvez les utiliser en fonction du contenu de votre site. Voici quelques-uns des plus importants :

- Article (Article): Idéal pour les articles de blog, les articles d'actualité et les instructions. Ce schéma met en évidence l'auteur, la date de publication et éventuellement une image.

- Organisation (Organization): Affiche des informations sur votre entreprise, telles que le nom de l'entreprise, le logo et les coordonnées, directement dans les résultats de recherche.

- Produit (Product): Particulièrement utile pour les sites de commerce électronique. Il contient des informations telles que le prix, la disponibilité et les évaluations.

- FAQ (Foire aux questions) : Ce schéma vous permet d'afficher les questions et réponses les plus fréquentes directement dans les résultats de recherche.

- Évaluations (revue) : Affiche les évaluations des utilisateurs et un résumé des évaluations, ce qui est particulièrement précieux pour les produits, les services ou les entreprises locales.

Conseil de lecture :

Google Developers : Introduction aux données structurées - Une introduction détaillée au fonctionnement et à l'implémentation des données structurées.

Création de schémas personnalisés

Alors que les types de schémas prédéfinis sont utiles, il peut y avoir des situations où vous devez créer un schéma personnalisé. Dans ce cas, RankMath offre une excellente flexibilité pour créer des balises spécifiques qui correspondent exactement à votre contenu.

Étapes de la création d'un schéma personnalisé :

- Étape 1 : Dans RankMath, choisissez "Schéma" > "Schéma personnalisé".

- Étape 2 : Définissez le nom et le type de schéma que vous souhaitez créer.

- Étape 3 : Ajoutez les champs pertinents en les saisissant manuellement ou en les sélectionnant dans une liste d'options prédéfinies.

- Étape 4 : Enregistrer et tester le schéma personnalisé à l'aide d'un outil de test des résultats enrichis.

Conseil Si vous avez besoin de schémas personnalisés plus complexes, vous pouvez également utiliser JSON-LD pour insérer le balisage directement dans le code HTML de votre page.

Conseil de lecture :

Schema.org : Guide des schémas personnalisés - Un guide sur la création de schémas personnalisés avec Schema.org.

Les rich snippets et leurs avantages

Les extraits enrichis sont des résultats de recherche spéciaux qui se distinguent par des données structurées. Ils offrent un contexte supplémentaire et des éléments visuels qui aident les utilisateurs à prendre une décision éclairée avant de cliquer sur un résultat de recherche.

Exemples de rich snippets :

- Évaluations et étoiles : Les produits ou services ayant fait l'objet d'une évaluation sont mis en évidence visuellement dans les résultats de recherche par une note en étoiles.

- Informations sur les prix : Les sites de commerce électronique peuvent afficher les prix directement dans les résultats de recherche, ce qui est particulièrement utile pour comparer les prix.

- Snippets de la FAQ : Les questions et les réponses apparaissent directement sous le lien principal, ce qui peut augmenter considérablement le taux de clics.

Avantages :

- Augmentation du taux de clics (CTR) : Les utilisateurs sont plus susceptibles de cliquer sur les résultats mis en évidence par des extraits enrichis, car ceux-ci fournissent des informations supplémentaires.

- Amélioration de la visibilité : Les extraits enrichis rendent vos résultats de recherche plus visibles et peuvent vous aider à vous démarquer de la concurrence.

- Meilleure expérience utilisateur : Les utilisateurs obtiennent plus d'informations en un coup d'œil, ce qui se traduit par une meilleure expérience utilisateur.

Conseil de lecture :

Yoast : Comment obtenir des snippets riches - Un guide complet sur la manière d'obtenir des extraits enrichis à l'aide du balisage Schema.org.

Tester et valider le balisage des schémas

Il ne suffit pas d'implémenter un balisage de schéma sur votre site. Vous devez vous assurer qu'il fonctionne correctement et qu'il est reconnu par les moteurs de recherche. Google propose des outils permettant de tester le balisage et de corriger les éventuelles erreurs.

Outils de validation :

- Test Google Rich Results : Cet outil vérifie si vos données structurées ont été correctement implémentées et si elles sont adaptées aux extraits enrichis.

- Google Search Console : Utilisez les rapports sur la couverture et les résultats riches pour identifier et résoudre les problèmes liés à vos données structurées.

Étapes de la validation :

- Étape 1 : Rendez-vous sur l'outil Google Rich Results Test Tool et saisissez l'URL de la page que vous souhaitez tester.

- Étape 2 : Analysez les résultats et corrigez les éventuelles erreurs qui s'affichent.

- Étape 3 : Consultez régulièrement la Google Search Console pour détecter les avertissements ou les erreurs concernant vos données structurées.

Conseil de lecture :

Google Developers : outil de test de données structurées - Un outil de vérification et de validation de vos données structurées.

Schema.org : Introduction - Une introduction au monde des données structurées et à leur fonctionnement.

Des données structurées selon schema.org sont indispensables

L'implémentation du balisage Schema.org sur votre site web est l'une des méthodes les plus efficaces pour améliorer la présentation de votre contenu dans les résultats de recherche. En utilisant des outils tels que Yoast SEO et RankMath, vous pouvez insérer des données structurées de manière simple et efficace. Les rich snippets générés par le balisage structuré vous offrent la possibilité d'augmenter de manière significative votre visibilité et votre taux de clics. Vérifiez et validez régulièrement vos données structurées afin de vous assurer qu'elles fonctionnent correctement et vous donnent les meilleurs résultats. Vous trouverez d'autres informations détaillées dans mon Guide SEO de Yoast.

Core Web Vitals : la performance rencontre l'expérience utilisateur

Les Core Web Vitals sont un élément essentiel du référencement technique. Ils mesurent la vitesse de chargement, l'interactivité et la stabilité visuelle de votre site web. Depuis que Google a introduit ces métriques comme facteur de classement, elles sont devenues un aspect central pour satisfaire non seulement les moteurs de recherche, mais aussi les utilisateurs. Un site web rapide, stable et convivial permet d'obtenir un meilleur classement et une meilleure expérience utilisateur.

Que sont les Core Web Vitals ?

Les Core Web Vitals comprennent quatre métriques principales qui sont essentielles à l'évaluation de l'expérience utilisateur :

- Largest Contentful Paint (LCP) : Mesure la vitesse à laquelle le contenu principal d'une page se charge. Une bonne valeur LCP est inférieure à 2,5 secondes.

- Délai de première entrée (FID) : Évalue la réactivité de la page. Un FID inférieur à 100 millisecondes est considéré comme bon.

- Décalage cumulatif de la mise en page (CLS) : Mesure la stabilité visuelle d'une page. Une valeur stable est inférieure à 0,1, ce qui signifie que la mise en page de la page ne se déplace pratiquement pas pendant son chargement.

- Interaction avec la peinture suivante (INP) : Une nouvelle métrique qui mesure la rapidité avec laquelle une page réagit aux interactions des utilisateurs. Une valeur inférieure à 200 millisecondes est considérée comme bonne.

Pourquoi ces métriques sont-elles importantes ?

Les moteurs de recherche comme Google utilisent ces métriques pour déterminer si votre site web est convivial. Un site optimisé offre une meilleure expérience utilisateur et est mieux classé dans les résultats de recherche.

Conseil de lecture :

Google PageSpeed Insights - Analysez les performances de votre site web et obtenez des propositions concrètes d'optimisation.

Optimisation de Largest Contentful Paint (LCP)

Le LCP est l'une des métriques les plus importantes, car il mesure le temps de chargement du contenu principal. Plus le contenu principal se charge rapidement, meilleure est l'expérience de l'utilisateur.

Les étapes de l'optimisation :

- Compression d'images : Utilisez des formats d'image optimisés comme WebP et compressez les images pour réduire le temps de chargement.

- Chargement paresseux : Implémenter le chargement paresseux (lazy loading) pour ne charger les images que lorsqu'elles apparaissent dans la zone visible.

- Améliorer le temps de réponse du serveur : Réduisez le temps de réponse du serveur en utilisant un réseau de diffusion de contenu (CDN) et en utilisant des serveurs rapides.

- Élimination des éléments de blocage du rendu : Évitez les fichiers CSS et JavaScript inutiles qui pourraient retarder le chargement du contenu principal.

Conseil Utilisez des outils tels que Google PageSpeed Insights ou Lighthouse pour obtenir des recommandations spécifiques afin d'améliorer votre LCP.

Conseil de lecture :

Google Developers : Optimiser LCP - Instructions détaillées sur l'optimisation du Largest Contentful Paint.

Amélioration du délai de première entrée (FID)

Le FID mesure la rapidité de réaction de votre site web à la première interaction de l'utilisateur. Un temps de réaction rapide permet d'éviter que les visiteurs ne quittent le site frustrés.

Les étapes de l'optimisation :

- Minimisation de JavaScript : Réduisez le nombre et la taille des fichiers JavaScript. Les opérations JavaScript inutiles doivent être évitées.

- Chargement asynchrone : Chargez les fichiers JavaScript de manière asynchrone afin qu'ils ne bloquent pas la page principale.

- Donner la priorité aux ressources prêtes à interagir : Assurez-vous que les éléments avec lesquels les utilisateurs interagissent se chargent aussi rapidement que possible, par exemple les boutons et les formulaires.

Conseil Une complexité réduite du code et une exécution optimisée des scripts contribuent à améliorer la réactivité.

Conseil de lecture :

Google Developers : Optimize FID - Conseils et stratégies pour optimiser le délai de première entrée.

Réduction du Cumulative Layout Shift (CLS)

Le CLS mesure la stabilité visuelle d'une page. Si le contenu se déplace pendant le chargement, cela peut nuire à l'expérience utilisateur. Un chargement stable des pages est donc essentiel.

Les étapes de l'optimisation :

- Espace réservé pour les images et les vidéos : Utilisez des dimensions fixes pour les images et les vidéos afin d'éviter les décalages de mise en page.

- Éviter les contenus dynamiques : Veillez à ne pas ajouter de nouveau contenu pendant le chargement, ce qui pourrait déplacer la mise en page.

- Optimisation des polices de caractères : Chargez les polices de manière à ce qu'elles ne retardent pas ou ne déplacent pas la mise en page. Utilisez pour cela la propriété CSS

affichage des polices : swap.

Conseil Examinez votre site web à l'aide d'outils tels que Lighthouse afin d'identifier et de corriger les décalages de mise en page spécifiques.

Conseil de lecture :

Google Developers : Optimize CLS - Guide pour améliorer la stabilité visuelle de votre site web.

Optimisation de l'Interaction to Next Paint (INP)

L'INP est une métrique relativement récente qui mesure la réactivité d'une page aux interactions des utilisateurs tout au long de son cycle de vie. Contrairement au FID, qui n'évalue que la première interaction, l'INP mesure le temps de réaction pour chaque interaction qui a lieu après le chargement de la page.

Les étapes de l'optimisation :

- Réduire JavaScript : Minimiser le JavaScript exécuté lors d'un clic, d'un défilement ou d'autres interactions afin d'éviter les retards.

- Donner la priorité aux éléments nécessitant beaucoup d'interaction : Veillez à ce que les éléments interactifs tels que les boutons et les menus soient prioritaires et réagissent le plus rapidement possible.

- Optimisation du thread principal : Gardez le thread principal libre de tâches longues qui pourraient nuire à la réactivité.

Conseil Utilisez Lighthouse ou Chrome DevTools pour surveiller et optimiser les valeurs INP de votre site.

Conseil de lecture :

Google Developers : Optimize INP - Un guide pour optimiser le temps d'interaction sur votre site web.

Outils de contrôle et d'optimisation des Core Web Vitals

L'optimisation des Core Web Vitals nécessite une surveillance et des ajustements continus. Utilisez pour cela des outils spécialisés qui vous offrent des aperçus détaillés et des recommandations d'action.

Outils recommandés :

- Google PageSpeed Insights : Offre un aperçu complet des Core Web Vitals de votre site web et donne des conseils d'optimisation ciblés.

- Lighthouse : Un outil open source de Google intégré à Chrome. Il analyse votre site web et fournit des rapports détaillés sur les quatre métriques.

- Google Search Console : Le rapport "Core Web Vitals" de la Search Console indique les performances de vos pages dans les Core Web Vitals et signale les problèmes.

Conseil Combinez ces outils pour obtenir une analyse complète et effectuer des optimisations ciblées.

Conseil de lecture :

Le blog d'Ahref : Guide complet des vitrines web de base - Un guide complet pour optimiser les Core Web Vitals.

Le rôle de l'hébergement et de l'optimisation des serveurs

L'un des facteurs souvent négligés dans l'optimisation des Core Web Vitals est la qualité de l'hébergement et la configuration du serveur. Un serveur rapide et une configuration de serveur optimisée peuvent réduire considérablement les temps de chargement.

Les meilleures pratiques :

- Choisir le bon hébergement : Profitez d'un hébergement performant, optimisé pour la vitesse et la stabilité.

- Mise en cache du serveur : Mettre en œuvre la mise en cache du serveur pour réduire les temps de chargement. Des outils tels que Varnish Cache peuvent vous y aider.

- Utiliser HTTP/2 et HTTP/3 : Assurez-vous que votre serveur prend en charge HTTP/2 ou HTTP/3 afin d'améliorer la vitesse de chargement et d'augmenter l'efficacité.

Conseil Veillez à ce que votre hébergeur propose régulièrement des mises à jour et des correctifs de sécurité afin de garantir les performances et la sécurité de votre site.

Conseil de lecture :

Search Engine Journal : Optimisation du serveur pour les vitrines web de base - Un guide pour optimiser votre serveur afin d'obtenir de meilleurs vitaux web.

Comment améliorer les Core Web Vitals de manière ciblée et optimiser votre site web à long terme

Les Core Web Vitals jouent un rôle central dans l'évaluation de l'expérience utilisateur sur votre site web. L'optimisation continue de ces métriques permet non seulement d'améliorer le classement dans les moteurs de recherche, mais aussi d'augmenter la satisfaction de vos visiteurs. En vous concentrant sur l'amélioration de la vitesse de chargement, de l'interactivité et de la stabilité visuelle, vous créez une base solide pour le succès de votre site web.

Utilisez les stratégies et les outils présentés ici pour prendre des mesures ciblées afin d'optimiser les Core Web Vitals. N'oubliez pas qu'un site web techniquement irréprochable et convivial répond non seulement aux exigences actuelles, mais permet également de mieux faire face aux évolutions futures du marketing numérique.

Ne manquez pas l'occasion de faire passer votre site au niveau supérieur, tant aux yeux des utilisateurs que des moteurs de recherche. Vous trouverez d'autres informations détaillées et des instructions spécifiques dans mon Guide SEO de YoastIl vous aidera à renforcer votre stratégie globale de référencement.

Liste de contrôle technique SEO pour 2024 : guide pas à pas

Afin d'optimiser votre site web de manière irréprochable sur le plan technique et de répondre aux normes actuelles en matière de référencement, j'ai rédigé pour vous une check-list détaillée du référencement technique. Ce guide vous aide à vérifier et à optimiser tous les aspects importants du référencement technique. Chaque étape est conçue pour rendre votre site web accessible et performant, tant pour les moteurs de recherche que pour les utilisateurs :

Conseil n° 1 : actualiser régulièrement le plan du site

- Étape 1 : Ouvrez votre tableau de bord WordPress et naviguez vers les paramètres du plugin SEO, soit Yoast SEO ou RankMath.

- Étape 2 : Assurez-vous que le sitemap XML est activé et que toutes les pages, contributions, catégories et balises pertinentes sont couvertes.

- Étape 3 : Vérifiez si le sitemap a été correctement soumis à la Google Search Console. Vous pouvez le vérifier sous "Index" > "Sitemaps" dans la Search Console.

- Étape 4 : Actualisez manuellement le plan du site si vous avez apporté des modifications importantes à votre site, comme l'ajout ou la suppression de pages.

Conseil N'oubliez pas de soumettre le plan du site à d'autres moteurs de recherche tels que Bing et Yandex afin de maximiser l'indexation.

Conseil n° 2 : vérifier le fichier Robots.txt

- Étape 1 : Dans le tableau de bord WordPress, allez à "SEO" > "Outils" (Yoast SEO) ou "RankMath" > "Paramètres généraux" > "Editer Robots.txt".

- Étape 2 : Vérifiez quelles parties de votre site sont bloquées ou autorisées pour les moteurs de recherche.

- Étape 3 : Veillez à ce qu'aucune page importante, comme vos catégories principales ou vos pages de renvoi, ne soit bloquée par inadvertance.

- Étape 4 : Testez votre fichier Robots.txt avec le testeur Robots.txt de la Google Search Console pour vous assurer qu'il ne contient pas d'erreurs.

Remarque : Veillez à ce que les zones sensibles de votre site, comme le répertoire d'administration ou certains contenus privés, soient exclues de l'indexation.

Conseil n° 3 : surveiller l'état de l'indexation

- Étape 1 : Connectez-vous à la Google Search Console et accédez au rapport "Couverture" sous "Index".

- Étape 2 : Vérifier quelles pages ont été indexées et quelles erreurs ou avertissements sont apparus.

- Étape 3 : Corriger les erreurs telles que "Page introuvable" (404) ou "Page bloquée par Robots.txt" pour s'assurer que les contenus importants sont indexés.

- Étape 4 : Soumettez manuellement des pages individuelles à l'indexation si vous avez effectué des modifications importantes et que vous souhaitez vous assurer qu'elles seront rapidement reconnues.

Conseil Utilisez la fonction "Vérification de l'URL" dans la Google Search Console pour vérifier l'état actuel de l'indexation d'une page donnée.

Conseil n° 4 : utiliser des données structurées

- Étape 1 : Navigue vers les paramètres du plug-in SEO (Yoast SEO ou RankMath) et ouvre la section des données structurées ou du balisage de schéma.

- Étape 2 : Choisissez le schéma approprié pour votre contenu, comme par exemple "Article", "HowTo", "FAQ" ou "Product".

- Étape 3 : Remplissez les champs pertinents, tels que le titre, la description, l'auteur, la date de publication et les éventuelles informations complémentaires (p. ex. évaluation, prix).

- Étape 4 : Testez vos données structurées à l'aide de l'outil Google Rich Results Test Tool pour vous assurer qu'elles sont correctement implémentées et adaptées aux extraits enrichis.

Remarque : Les données structurées peuvent améliorer considérablement la présentation de votre site dans les résultats de recherche et augmenter le taux de clics.

Conseil n° 5 : optimiser les Core Web Vitals

- Étape 1 : Visitez Google PageSpeed Insights et saisissez l'URL de votre site pour vérifier les Core Web Vitals.

- Étape 2 : Analysez les trois métriques principales : Largest Contentful Paint (LCP), First Input Delay (FID) et Cumulative Layout Shift (CLS).

- Étape 3 : Réduisez le temps de chargement de votre site web en prenant des mesures telles que la compression des images, la minification de CSS et de JavaScript et l'utilisation d'un réseau de diffusion de contenu (CDN).

- Étape 4 : Optimisez l'interactivité de votre site en réduisant les charges JavaScript inutiles et en veillant à ce que les ressources importantes soient chargées en priorité.

- Étape 5 : Minimisez les décalages de mise en page en définissant des tailles fixes pour les images et les vidéos et en chargeant efficacement les polices de caractères.

Conseil Utilisez l'outil de navigation Lighthouse pour obtenir des rapports plus détaillés et des propositions d'optimisation spécifiques.

Votre clé pour une stratégie SEO réussie : maîtriser les optimisations techniques

Le SEO technique peut sembler complexe, mais il constitue la base de toute stratégie de référencement réussie. En optimisant de manière ciblée la crawlabilité, l'indexation, Schema.org et les Core Web Vitals de votre site, vous posez les bases d'une meilleure visibilité et d'un meilleur classement dans les moteurs de recherche. Utilisez les outils puissants proposés par Yoast SEO et RankMath pour maîtriser ces aspects techniques et renforcer durablement votre site web.

En procédant à ces optimisations de manière continue, vous n'apportez pas seulement des améliorations immédiates, mais vous préparez également votre site web aux défis futurs. Si vous souhaitez approfondir les bases techniques, jetez un coup d'œil sur mon guide SEO Yoast détaillé - Votre prochaine étape vers un succès SEO à long terme.

Suggestions de lecture complémentaires :

- Google Search Central : Exploration et indexation

- Moz : Le guide du débutant en SEO

- Schema.org : Introduction

- Google PageSpeed Insights

- Search Engine Journal : Guide technique SEO

Vous souhaitez vous plonger plus profondément dans un sujet particulier ou vous avez des questions spécifiques ? Utilisez la fonction de commentaire, je me réjouis de vos réflexions et de vos questions !

0 commentaires